Il est de bon ton de s’émerveiller devant les prouesses d’exhaustivité et de précision dont Chat GPT se montre capable, mais certaines applications de l’IA – au sens général du terme – ne semblent pas bénéficier de la mise en lumière qu’elles mériteraient au regard de leur potentiel scientifique en pleine éclosion. Si les lois qui régissent l’Univers ont été découvertes par le génie humain (Einstein, Friedmann, Lemaître) et l’observation du Cosmos (Hubble) à un époque où les ordinateurs n’existaient pas, de plus en plus d’astrophysiciens sollicitent l’aide du machine learning afin de mieux comprendre un Univers qui n’a pas encore livré tous ces mystères. En 2018, des scientifiques de plusieurs pays ont ainsi fondé le Consortium Aquila, qui promeut l’utilisation des dernières innovations en IA dans le domaine de l’astrophysique. Au-delà de l’effet de mode et des buzzwords (phénomène qu’on peut parfois déplorer autour de l’IA), comment et dans quelle mesure cette dernière peut-elle être un outil précieux pour les astrophysiciens ?

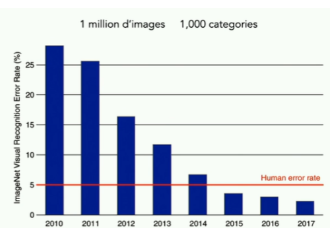

Précisons tout d’abord que les chercheurs n’ont pas attendu l’intelligence artificielle et le machine learning (entendu comme un sous ensemble de l’IA) pour s’aider d’outils techniques de traitement d’images de l’Univers. Depuis les années 1960, les images prises par les télescopes sont en effet analysées par des outils statistiques, mais ceux-ci n’ont connu que des progrès incrémentaux entre les années 1960 et les années 2000. Du fait de l’essor du deep learning, 2012 est apparue comme une année charnière pour le machine learning, avec la multiplication d’initiatives et des succès jusqu’alors sans précédent dans le domaine de l’IA. Cette année-là, le réseau de neurone du projet Google Brain a par exemple « découvert » le concept de chat sans qu’on ne lui ait jamais enseigné, et est donc devenu capable d’identifier l’animal en vidéo. A partir des années 2010, le machine learning n’est donc plus synonyme de mémorisation massive de données par une « machine » et il s’agit désormais pour celle-ci d’« apprendre à apprendre » afin qu’elle puisse développer des stratégies et « raisonner » . Entre 2020 et 2022, l’IA DeepMind a réussi à déterminer avec précision la structurer 3D de l’ensemble (200 millions) des protéines connues, ce qui était jusqu’à présent un épineux défi pour les biologistes. Les récents bonds en avant de la technologie en matière d’intelligence artificielle sont susceptibles d’être mis à profit d’autres disciplines scientifiques, comme l’astronomie et l’astrophysique.

Diminution du taux d’erreur de la reconnaissance d’image par des réseaux de neurones. Source : Institut d’Astrophysique de Paris

L’IA apparait tout d’abord comme un accélérateur potentiel de la recherche en astrophysique sur un plan quantitatif. Les progrès de l’observation de l’Univers ont permis de collecter des quantités astronomiques de données, dont l’exploitation est nécessairement limitée par le temps et les moyens dont disposent les scientifiques. Il faudrait par exemple plus de 50 ans pour analyser « manuellement » les données du département d’astronomie de la seule Université d’État du Nouveau-Mexique. On dispose donc actuellement d’un milliard d’images de l’Univers, captées par les télescopes terrestres (qui coûtent des centaines de millions d’euros) et spatiaux (qui en coutent des dizaine de milliards). A quoi bon tous ces investissement et ses efforts si seule une faible portion de données collectées peut être analysée ?

En novembre 2024, le programme Legacy Survey of Space and Time de l’observatoire Vera-C.-Rubin au Chili débutera ses activités. Pendant dix ans, son télescope collectera jusqu’à 500 pétaoctets d’images, c’est-à-dire plus de 50 000 fois la quantité de données collectées par le télescope Hubble sur une même période. Pour les cosmologistes, cette moisson vertigineuse de données pourrait s’avérer particulièrement fructueuses, à condition d’optimiser son traitement en aval. Brice Ménard (astrophysicien enseignant à John Hopkins) explique que les images les plus « belles » de l’Univers sont aussi les plus dures à analyser du fait du fourmillent d’informations à extraire. La richesse de ces images pose ainsi un double enjeu d’exhaustivité et de rapidité de traitement. Dans ce contexte, les réseaux de neurones pourraient donc être l’outil permettant de trouver une ou plusieurs aiguilles dans la botte de foin cosmique.

Evoquons aussi une dimension « qualitative » : outre la capacité de traitement évoquée, la valeur ajoutée du réseau de neurone par rapport à l’humain et la capacité à reconnaitre des objets même quand ils sont présents à l’image de manière parcellaire ou fragmentée. En d’autres termes, une IA est capable de repérer des éléments qui seraient passés inaperçus pour l’œil humain. L’image processing (réduction du bruit et hausse de la résolution) permet aussi d’obtenir des images plus exploitables, ce qui facilite par exemple l’identification d’objets et de phénomènes inhabituels et rares. Rappelons que pour décrire une réalité donnée, le cerveau humain est nécessairement limité par son langage, chaque langue présentant ses avantages et limites inhérentes. L’astrophysicien Brice Ménard explique à ce sujet que l’IA pourrait palier la dimension limitante du langage humain, ce qui peut s’avérer utile en matière d’astrophysique, en particulier pour l’interprétation d’images du Cosmos.

Ayant établi en quoi le machine learning et les réseaux de neurones apportent une aide aux scientifiques, citons quelles exemples concrets du potentiel rôle de l’IA en la matière:

- Caractériser la texture de l’univers : amplitude et forme des fluctuations, vitesse d’expansion, densité. Très concrètement, la capacité des réseaux de neurones à « voir différemment » de l’œil humain pourrait se révéler utile quand on remonte l’observation de l’univers au-delà de 10 milliards d’années, la lumière qui arrive jusqu’au télescope étant alors trop faible pour former une image complète et intelligible. Par ailleurs, les futures données du télescope de l’observatoire Vera-C.-Rubin pourraient fournir l’information permettant d’affiner la mesure exacte de la constante Hubble-Lemaître, autre nom donné à la vitesse d’expansion de l’univers.

- Tri et classification, notamment des galaxies, dont les images permettent de les catégoriser (spirales, elliptiques, avec et sans noyaux), et dont les spectres permettent d’estimer leur distance dans l’Univers.

- Simulation permettant aux scientifiques de mieux comprendre des phénomènes comme l’évolution des galaxies et formation des trous noirs.

- Prospective : l’analyse d’un volume considérable de données empiriques permet à l’IA de pouvoir identifier des patterns qui permettraient de « prédire » certains évènements astronomiques (supernova, sursaut gamma).

Du fait de leur complexité, les applications en astrophysique pourraient également permettre au machine learning de mieux « apprendre à apprendre ». Les deux disciplines (IA et astrophysique) peuvent donc s’alimenter mutuellement dans une synergie positive.

Du fait des bonds quantitatifs et qualitatifs qu’elle rend possible, l’intelligence artificielle semble ainsi amenée à jouer un rôle significatif dans les futures recherches en astrophysique. Le machine learning pourrait en effet permettre aux scientifiques de percer à jour certaines thématiques qui demeurent nappées d’un halo de mystère, à l’instar de l’énergie noire. Il faut néanmoins se prémunir contre toute surinterprétation et tout optimisme exacerbé qui confineraient au sensationnalisme. Si l’IA bénéficie de fait d’une supériorité sur l’homme dans la détection et classification de données massives et d’informations parcellaires, les réseaux de neurones présentent également des angles morts et le machine learning forme un « langage interne » qui comprend une certaine part d’opacité. Brice Ménard parle ainsi du « challenge » consistant à décrypter le langage interne des réseaux de neurones, suggérant par la même qu’un recours excessif à ce type d’outil pourrait grever les recherches d’une problématique méthodologique.

Aurélien Bacot, Consultant Senior chez Antidox