Le 22 janvier dernier, un post Twitter de la militante féministe et antiraciste @Mélusine_2 se voit sanctionné par le réseau social quelques heures après sa publication. L’objet du délit ? Une question mettant le doigt sur un problème sociétal brûlant, à l’heure des mouvements #MeToo, #MeTooInceste ou encore #MeTooGay : « Comment fait-on pour que les hommes arrêtent de violer ? ». Des utilisateurs se seraient plaints à Twitter d’une publication qui mettrait illégitimement tous les hommes dans le camp des violeurs. Des signalements ensuite modérés et validés par les algorithmes de la plateforme. Résultat : @Mélusine_2 a vu son compte suspendu pour « conduite haineuse », avec possibilité de le réactiver si, et seulement si, elle supprimait son post.

Suspension du compte @Mélusine_2 : la partie immergée de l’iceberg

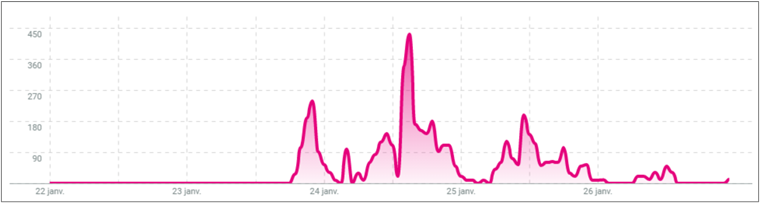

Cette sanction, qui s’est par la suite étendue à d’autres comptes féministes ayant relayé l’information, a suscité de nombreuses réactions en ligne, la plupart soutenant la militante et interpellant Twitter sur les dessous de ses algorithmes. Entre le 22 et le 26 janvier, le compte de @Mélusine_2 a ainsi été mentionné pas moins de 24 000 fois, tandis que le hashtag #CommentFairePourQueLesHommesArretentDeVioler est devenu viral dès le 23 janvier et a comptabilisé presque 5 000 mentions en 4 jours.

Mentions du hashtag #CommentFairePourQueLesHommesArretentDeVioler entre le 22 et le 26 janvier 2021 (source : Talkwalker)

Parmi ces réactions, des comptes féministes, comme celui de Caroline de Haas, à l’origine du collectif Nous toutes, mais pas que. Un tweet sur trois mentionnant le hashtag a été publié par… un homme. Face à cet emballement, les grands médias, comme France Inter ou Le Huffington Post, ne tardent pas à reprendre l’information, tandis que Mélusine continue de faire entendre sa voix grâce notamment à une tribune dans Libération le 29 janvier.

Entre-temps, Twitter s’est excusé mais la question est plus que jamais au cœur du débat : quelle réelle efficacité peut-on attendre des algorithmes de modération des réseaux sociaux ? Doit-on laisser toute puissance à ces logiciels qui manquent parfois de mise en contexte ? Car ce qui est arrivé à Mélusine est bien loin d’être anecdotique : toutes les plateformes comme toutes les sphères d’expression (et pas que militantes et politiques) sont concernées.

« Un algorithme n’est en réalité qu’une opinion intégrée aux programmes »

La mécanique des algorithmes comporte encore clairement certaines lacunes, à commencer par la compréhension du langage, si naturel aux êtres humains et pourtant si complexe à intégrer dans des outils technologiques. Distinguer une affirmation d’une dénonciation, identifier l’émotion ou le sarcasme, analyser le contexte entourant des mots-clés sensibles comme « viol » : un travail rendu plus qu’ardu pour un algorithme. D’autant plus face à des controverses sociétales faisant apparaître au grand jour l’expression d’opinions pour le moins différentes mais tout autant légitimes.

Car n’oublions pas qu’à l’origine des décisions de modération des plateformes, se trouvent bien souvent des signalements de membres. Stéréotyper l’ensemble des hommes en les catégorisant comme des violeurs, c’est ce qu’ont ainsi désapprouvé certains utilisateurs face au tweet de @Mélusine_2. Alors, qui doit l’emporter ? Un tweet dénonciateur ou la désapprobation d’un collectif ? Face à de telles complexités sociétales, comment peut-on attendre une prise de décision juste et irréprochable de la part de simples algorithmes ?

On aurait alors tort de pointer du doigt uniquement les failles technologiques sans voir derrière elles les failles humaines. Comme l’explique la mathématicienne spécialiste de la question, Cathy O’Neil : « un algorithme n’est en réalité qu’une opinion intégrée aux programmes ». Car oui, derrière ces logiciels se cachent évidemment un important travail humain de conception et de modération, nécessairement biaisés. Cette importance du biais est à prendre en compte dès la création même des outils. Un rapport de l’Institut Montaigne publié en mars dernier rappelle ainsi très justement qu’en France, « la plupart des développeurs ont été formés aux mathématiques appliquées, aux statistiques et à l’informatique, sans formation spécialisée en sciences sociales ». Les complexités de nos enjeux sociétaux se retrouvent alors bien souvent les grands oubliés de la conception de ces algorithmes.

L’humain se retrouve ensuite au cœur du colossal travail de modération, nourrissant les algorithmes de leurs décisions. Facebook compterait ainsi au total 5 000 modérateurs, chacun évaluant environ 15.000 images par jour. Les milliers de travailleurs indépendants connectés chaque jour à la place de marché « Mechanical Turk » imaginée par Amazon – appelé aussi « MTurk » -, contribueraient également à ajuster ces algorithmes. Leur rôle ? Réaliser des micro-tâches comme lire des tweets de femmes disant avoir été harcelées ou encore signaler des images choquantes[1]. Mais cette intervention humaine s’avère-t-elle réellement suffisante ? Dans l’affaire Mélusine, Twitter le reconnaît lui-même : « bien que nous nous efforcions d’assurer la cohérence de nos systèmes, il peut arriver que le contexte apporté habituellement par nos équipes manque, nous amenant à commettre des erreurs ».

En d’autres termes, il est temps de se pencher sur cette question cruciale de l’encadrement des algorithmes, et plus largement du contrôle de l’information sur les réseaux sociaux, qui ne cesse de devenir un enjeu toujours plus majeur de nos sociétés ultra connectées. L’une des premières pistes aujourd’hui explorées recouvre l’augmentation du nombre et de la diversité culturelle des modérateurs humains. Cet été, Facebook s’est ainsi engagé à ce que la moitié de son personnel soit composé de personnes issues des minorités visibles d’ici 2023. Mais cela voudra-t-il pour autant dire que la diversité des opinions sera suffisante ? Un autre axe sur lequel beaucoup de chemin reste encore à parcourir est celui de la transparence, sous-tendant de fait un vrai travail pédagogique réalisé par les plateformes sur les dessous de leurs algorithmes. Enfin, les gouvernements ont eux aussi un rôle à jouer. Un rôle qui s’incarne d’ores et déjà à travers les débats législatifs actuels en Europe comme Outre-Atlantique sur les sujets complexes de haine en ligne et de fake news où les algorithmes ont d’ores et déjà montré leurs limites. En France, un amendement, intégré au projet de « loi contre le séparatisme », remet cette année sur la table le vaste projet de régulation des réseaux sociaux…

[1] « Le monde selon Amazon », Benoît Berthelot, 2019

Par Amélie Gillot, Consultante senior chez Antidox