Comme tout débat impliquant l’IA, l’utilisation de ces technologies dans la musique ne manquera pas de susciter des controverses sans fin, alimentées par des flux d’articles clickbait et de vidéos YouTube. Cet article tentera donc d’éviter le champ de bataille rageur du débat entre techno-enthousiastes et sceptiques à l’égard de l’IA. Nous nous concentrerons plutôt sur le potentiel réel de l’IA en tant qu’outil de production musicale (mixage & ; mastering) : comment l’IA peut-elle intervenir exactement, comment est-elle utilisée et comment son rôle pourrait-il évoluer à l’avenir ? Afin de fournir une vue d’ensemble cohérente de ce sujet spécifique, nous laisserons de côté le sujet de l’IA générative (musique entièrement créée par l’IA).

L’IA est une marée qui ne peut être arrêtée, et ses vagues s’écrasent déjà – doucement pour l’instant – sur les rivages de l’industrie musicale. Notre objectif ici n’est pas de débattre de la question de savoir si l’IA est « bonne » (une opportunité et une force) ou « mauvaise » (un piège et une menace) pour la musique en général, mais plutôt de dresser la carte des principales implications que cette évolution technologique aura – et a déjà eu – sur la production musicale. En d’autres termes, nous n’aborderons pas le sujet de la musique composée avec l’IA, mais nous explorerons plutôt comment l’intelligence artificielle peut agir comme un assistant pour les compositeurs et les producteurs.

Ce sujet se situe au carrefour de l’expression artistique et des considérations techniques. En effet, la musique est avant tout une forme d’art, avec sa part de mystère et sa réticence à entrer dans le cadre d’une approche scientifique objective. Mais la production musicale est aussi une tâche technique, articulant des concepts objectifs (fréquences, gamme dynamique…), et nécessitant des connaissances de base sur le son en tant que phénomène physique. Cet article s’efforce de démystifier le rôle naissant de l’IA dans la production musicale en se concentrant sur ses applications pratiques et son potentiel futur en tant qu’outil de transformation. Si certaines notions ne vous sont pas familières, un glossaire est fourni à la fin de cet article.

L’IA comme outil d’aide aux compositeurs ?

L’IA pourrait être une béquille d’inspiration pour les compositeurs qui se sentent bloqués dans une ornière à un moment ou à un autre. L’intelligence artificielle ne serait pas utilisée ici comme un outil de génération de sons, mais plutôt comme une encyclopédie interactive de théorie musicale. Par exemple, quelqu’un qui a du mal à trouver un bon pont pour sa chanson pourrait demander à l’IA de lui fournir trois pistes potentielles, qu’il pourrait ensuite modifier en fonction de ses goûts personnels. Un artiste cherchant à pimenter une progression d’accords pourrait également demander à l’IA de lui fournir des options pertinentes, classées de la plus conventionnelle à la plus exotique. L’intelligence artificielle agirait donc comme un outil de composition interactif, fournissant des réponses précises à toute question relative à la théorie musicale.

Avec l’aide d’ingénieurs méticuleux (ayant une idée claire de ce qu’ils veulent que l’IA « apprenne »), l’apprentissage automatique pourrait venir à la rescousse. La beauté de la musique réside dans le fait que les « règles » de la théorie musicale peuvent parfois être enfreintes et que le résultat sonne toujours bien. Pensez par exemple à une dissonance temporaire pour créer un « drame », ou à un accord qui n’appartient pas à la tonalité du morceau pour ajouter de la couleur. En fouillant dans de gigantesques bibliothèques musicales, l’apprentissage automatique pourrait aider l’IA à identifier de manière très détaillée de tels modèles de contournement efficace des règles. Cette « connaissance de terrain » de la musique dans sa forme la plus audacieuse pourrait alors être accessible à l’utilisateur final, lorsqu’il a besoin d’un peu d’aide de l’IA pour ajouter des saveurs non conventionnelles à sa chanson.

Jusqu’à présent, GPT-4 s’est révélé quelque peu décevant en matière de théorie musicale, incorporant souvent des notes erronées dans un accord ou une gamme donnés, par exemple. Ce n’est cependant pas une surprise : par définition, l’IA doit être entraînée pour être performante, et personne ne peut reprocher aux ingénieurs d’OpenAI de ne pas avoir fait de la musique leur priorité absolue. Avec un peu de travail en amont et une bonne dose de réflexivité, l’IA pourrait agir comme l’ultime intello de la théorie musicale, capable de répondre à n’importe quelle question que vous pourriez avoir, et de proposer les modulations les plus folles pour votre chanson. Il est important de préciser que l’IA utilisée de cette manière ne devrait pas nécessairement générer de contenu audio, il peut très bien s’agir d’une simple interface de chatbot vous fournissant des progressions d’accords et des notes sans aucune sortie sonore. De cette manière, l’interface pourrait également avoir une dimension pédagogique et aider les gens à apprendre la théorie musicale d’une manière pratique et empirique.

Cependant, ne serait-il pas préférable d’apprendre le solfège soi-même plutôt que de s’en remettre à une IA ? Cela ne vous donnerait-il pas plus de liberté et, en fin de compte, plus de pouvoir en tant que créateur ? Que se passe-t-il si vous devez composer dans un endroit éloigné, sans connexion internet ? Plus important encore, on pourrait dire que l’implication de l’IA dans vos compositions va à l’encontre de l’objectif de la création musicale. Mais il s’agit là d’un autre débat, et passons maintenant à l’aspect production.

Le potentiel de l’IA dans la production musicale (mixage & ; mastering)

Lors du mastering d’un titre dans un studio parisien renommé, j’ai été surpris de voir l’ingénieur lancer un plugin d’auto mastering (un module d’IA qui analyse votre titre et vous propose des réglages de mastering). J’ai donc pu constater que l’utilisation de l’intelligence artificielle (bien qu’il s’agisse d’un outil soigneusement apprivoisé) faisait partie du processus quotidien d’un ingénieur de mixage chevronné. Entrons dans le vif du sujet.

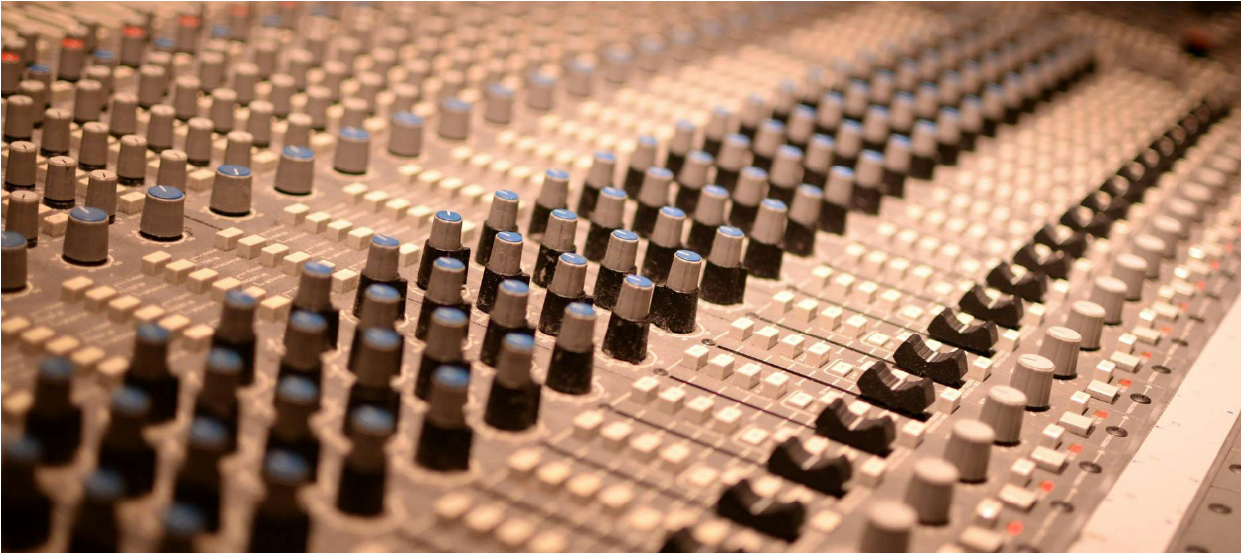

Le mixage consiste à traiter chaque piste audio d’une chanson donnée afin d’obtenir un son cohérent. Par exemple, vous réglerez les niveaux de chaque instrument de manière à ce qu’aucun ne prenne trop de place, vous réduirez les aigus des guitares ou des cymbales et augmenterez les médiums supérieurs de manière à ce que le chanteur « passe » un peu plus et puisse être mieux entendu sans être plus fort. On peut comparer le mixage à un Tetris musical, où chaque élément doit trouver sa propre place pour s’adapter à ses voisins fréquentiels. Le mastering peut être comparé à l’étape du polissage, où un mixage déjà solide est rendu beaucoup plus fort (via l’utilisation de matériel ou de plugins), et où quelques ajustements subtils sont apportés à l’égalisation globale de la piste et à l’image stéréo.

L’utilisation de l’IA dans la production audio est intéressante car le mixage est un processus à la fois artistique et technique. L’égalisation d’une guitare ou d’une basse est autant un choix artistique que technique : voulez-vous qu’elle soit plus brillante, plus sombre, plus éloignée ou plus proche ? Le mixage est toujours effectué pour atteindre un objectif spécifique, pour obtenir le son que le groupe a en tête pour son produit final. Le mixage joue en effet un rôle important dans la direction artistique d’un morceau de musique. Imaginez une chanson de rap moderne avec un registre de basses très faible, ou un nocturne de Chopin avec des aigus stridents et perçants…

S’il est toujours délicat d’introduire la notion d’objectivité dans la composition, il est beaucoup moins controversé de le faire dans le mixage, en particulier dans ses premières étapes, appelées « gain staging ». Le réglage de l’intensité sonore globale de chaque instrument est un aspect sur lequel l’IA peut vraiment briller, puisque les critères sont objectifs, en l’occurrence l’intensité sonore intégrée (exprimée en Db) de chaque piste audio de la chanson. Parfois, un instrument dans la chanson non mixée peut être vraiment « trop fort » pour un genre ou un contexte musical donné. Outre sa dimension créative, le mixage a en effet une dimension corrective : apprivoiser une fréquence trop forte, régler des problèmes de phase, compresser une partie trop dynamique… Pour cet aspect particulier, l’IA – dans toute sa froide objectivité – semble bien adaptée à la tâche. L’intelligence artificielle peut donc être un assistant de studio infatigable, chargé d’identifier les défauts sonores de la chanson auprès de l’ingénieur. Ce dernier devra alors décider si les éléments détectés doivent être corrigés ou non. De tels outils d’IA « analyse & ; conseil » existent déjà, comme les produits d’Izotope appelés Neutron et Ozone.

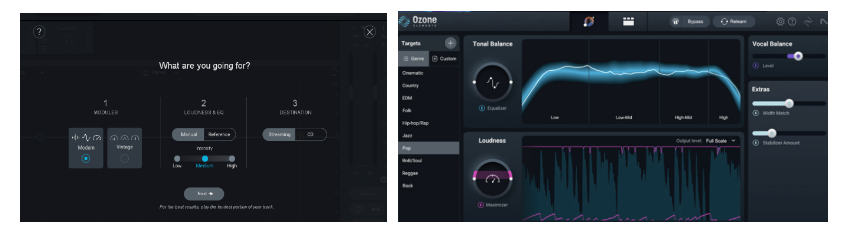

Il y a quelques années, le module « auto mastering » d’Ozone 9 n’avait que des réglages « moderne » et « vintage », mais Ozone 11 (sorti en 2023) incorpore des réglages bien plus détaillés. La société audio Izotope a en effet conçu plusieurs « préréglages » de masterisation (correspondant à différents styles de musique), ce qui a été rendu possible par l’apprentissage automatique, en l’occurrence l’« écoute » potentiellement exhaustive de centaines de milliers (voire de millions) de chansons de tous les genres et de toutes les époques. Grâce à cet apprentissage, l’IA « comprend » désormais ce qu’il faut faire pour atteindre un objectif sonore précis, par exemple renforcer les basses et améliorer le transitoire du kick pour un preset « rap », tandis qu’un preset « classique » préserverait une large plage dynamique et ouvrirait les hautes fréquences.

Les modules mastermind automatisés d’Ozone 9 et d’Ozone 11. La version 2019 n’avait que deux « styles » disponibles, tandis que la version 2023 en propose dix à l’utilisateur.

L’essai de plusieurs préréglages générés par l’IA pourrait aider les artistes et les ingénieurs du son à mieux affiner leur approche et à réaliser ce qu’ils recherchent au cours des étapes de mixage et de masterisation. Aujourd’hui, les plugins de masterisation automatisée fonctionnent comme des outils autonomes, c’est-à-dire qu’ils sont indépendants et ne sont pas conçus pour communiquer ou s’intégrer aux autres plugins que vous pourriez utiliser dans votre logiciel d’édition musicale (DAW). La prochaine étape sera très probablement l’intégration de modules d’IA dans les DAW (tels que ProTools ou REAPER). Ces modules pourraient – uniquement sur demande – prendre le contrôle de vos plugins de mixage pour vous proposer quelques mélanges différents à essayer. L’inconvénient de cette innovation est qu’elle pourrait empêcher les débutants d’apprendre véritablement à mixer, une compétence qui se développe grâce à un mélange de connaissances théoriques et d’expérience pratique incessante (essais et erreurs). Pourrait-il y avoir un risque de « dépendance à l’IA », les jeunes artistes étant tentés de s’appuyer fortement sur les merveilles de la technologie, ne développant donc jamais eux-mêmes des compétences en matière de mixage ? En tant qu’avocat de la défense de l’IA, on pourrait souligner que l’utilisateur de tels outils peut avoir une dimension pédagogique. L’utilisateur pourrait en effet voir comment les plugins sont utilisés par le module d’IA et comprendre la logique de ses modifications. Une fois de plus, l’intelligence artificielle pourrait ainsi jouer le rôle d’un enseignant empirique.

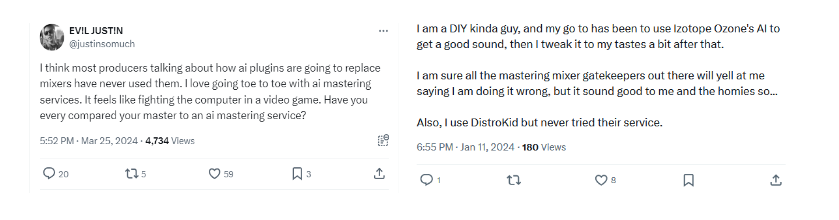

Les discussions sur les réseaux sociaux à propos du mixage et du mastering AI révèlent également que cette tendance suscite l’émulation parmi les producteurs de musique (amateurs ou professionnels). De nombreux utilisateurs s’amusent en effet à comparer leurs compétences avec les différents produits d’IA disponibles sur le marché, se vantant parfois de la meilleure qualité sonore de leur travail, admettant parfois leur surprise quant aux performances de l’IA. Par exemple, ce tweet posté le 25 mars plaide en faveur d’une concurrence saine et stimulante entre les producteurs et l’IA, comparant cette dernière à un adversaire de jeu vidéo.

Conclusion

Devons-nous nous préparer au jour où ce mixage a été conçu par l’IA deviendra le plus grand compliment du studio, et où même les oreilles d’or des ingénieurs du son chevronnés ne pourront rivaliser avec la précision tranchante de l’IA ? Peut-être pas, du moins pas encore. Toutefois, les progrès de l’apprentissage automatique et du traitement audio ne feront qu’accélérer l’arrivée massive de l’IA en tant qu’ingénieur de mixage adjoint. La technologie est déjà utilisée comme un outil pour détecter les défauts, gagner du temps, essayer de nouveaux réglages et cartographier le champ des possibles afin d’aider quelqu’un à trouver ce qu’il cherche.

If one does not need to be a boomer to doubt the likelihood of a fully AI-created hit song anytime soon, artificial intelligence will undoubtedly make it easier for artists to achieve professional-sounding mixes.

L’utilisation de l’IA dans la musique ne sera clairement pas perçue et jugée de la même manière, selon que la technologie a été utilisée dans la phase de création ou de production. L’IA sera sans doute beaucoup plus furtive (voire totalement méconnaissable de l’intervention humaine) dans la phase de mixage et de mastering. Compte tenu de variables telles que l’ego et la réputation, quel artiste sera enclin à admettre sans vergogne dans une interview que son dernier morceau a été entièrement composé par l’IA ? En revanche, qui reprochera à un ingénieur de mixage d’utiliser l’IA pour gagner du temps dans l’égalisation de la chanson de son client ? Si vous considérez la musique comme un fragile château de sable, soyez assurés qu’il ne sera pas détruit de sitôt par la froide et impitoyable marée de l’IA. Les murs du château seront encore de plus en plus entachés par quelques vagues audacieuses, et le résultat final sera encore une surprise de l’aventure artistique et technologique humaine.

Aurélien Bacot, consultant senior chez Antidox

Glossaire :

DAW (Digital Audio Workstation) : le programme que vous utilisez sur votre ordinateur pour stocker, visualiser, organiser et modifier les fichiers audio que vous enregistrez avec votre interface audio. Le célèbre logiciel « Audacity » est par exemple une DAW (très simple). Autres DAW célèbres : Reaper, ProTools, Cubase….

Plugin : un logiciel complémentaire que vous utilisez dans votre programme DAW pour appliquer des effets (délai, réverbération, saturation, compression) à votre audio. Par exemple, un plugin de réverbération simulera la réverbération d’une salle de concert, et votre plugin d’égalisation vous permettra d’augmenter ou de réduire n’importe quelle fréquence.

Compression: réduire le volume des sons forts ou amplifier les sons faibles en réduisant la plage dynamique, ce qui rend l’audio plus cohérent en termes de volume, avec moins de pics.

Égalisation (EQ): réglage de l’équilibre entre les fréquences au sein d’un signal audio, par exemple en réduisant les aigus durs ou les fréquences moyennes « nasales ».